No obstante, como suele ocurrir cuando se introducen cambios en la privacidad y la seguridad digitales, los expertos en tecnología no tardaron en identificar los inconvenientes: la estrategia de Apple para analizar las fotografías privadas de las personas podría darles a las autoridades policiales y a los gobiernos una nueva manera de vigilar a los ciudadanos y perseguir a los disidentes. Argumentaron que, una vez que se identifica un chip en el blindaje de la privacidad, cualquiera puede atacarlo.

Las preocupaciones discordantes pusieron de manifiesto un problema espinoso que la industria tecnológica no parece estar más cerca de resolver hoy que hace cinco años, cuando Apple se enfrentó por primera vez al FBI por el iPhone de un terrorista muerto.

La tecnología que protege la privacidad del ciudadano común también puede obstaculizar las investigaciones penales, pero la alternativa, de acuerdo con los grupos de defensa de la privacidad y muchos expertos en seguridad, sería peor.

Una vez que se crea esa puerta trasera, la usarán personas que no quieres que la usen, señaló Eva Galperin, directora de ciberseguridad de la Electronic Frontier Foundation, un grupo de defensa de los derechos digitales. No se trata de un daño teórico, sino de un daño que hemos visto que ocurre una y otra vez.

Apple no esperaba esta reacción. Cuando la empresa anunció los cambios, les envió a los periodistas complejas explicaciones técnicas y declaraciones elogiosas de grupos de seguridad infantil, de científicos de la computación y de Eric Holder hijo, el exfiscal general de Estados Unidos. Después de que la noticia se hizo pública, un portavoz de Apple le envió a un periodista un correo electrónico con una publicación en Twitter de Ashton Kutcher (el actor que ayudó a fundar un grupo que lucha contra los abusos sexuales a menores) en la que aplaudía las medidas.

No obstante, silenciaron su voz en gran medida. Expertos en ciberseguridad, el director de la aplicación de mensajería WhatsApp y Edward Snowden, el excontratista de inteligencia que filtró documentos clasificados sobre la vigilancia del gobierno, denunciaron la medida como un precedente peligroso que podría permitirles a los gobiernos revisar los teléfonos privados de las personas.

Apple programó cuatro sesiones informativas más para combatir lo que, según dijo, eran malentendidos, admitió que había cometido un error en la comunicación de su mensaje y anunció nuevas medidas de defensa destinadas a resolver algunas preocupaciones. Más de 8000 personas respondieron con una carta abierta en la que le pedían a Apple que detuviera sus acciones.

Por el momento, Apple ha dicho que seguirá adelante con sus planes, pero la empresa se encuentra en una posición precaria. Durante años, ha trabajado para hacer que los iPhones sean más seguros y, a su vez, ha hecho de la privacidad un elemento central de su estrategia de mercadotecnia; sin embargo, lo que ha sido bueno para el negocio también ha resultado ser malo para los niños violentados.

Hace unos años, el Centro Nacional para Niños Desaparecidos y Explotados empezó a revelar la frecuencia con la que las empresas tecnológicas denunciaban casos de material de abuso sexual infantil, conocido como pornografía infantil, en sus productos.

Apple se encontraba entre los últimos puestos. La empresa informó a las autoridades de 265 casos el año pasado, en comparación con los 20,3 millones de Facebook. Esta enorme diferencia se debe, en gran medida, a que Apple decidió no buscar esas imágenes para proteger la privacidad de sus usuarios.

A finales de 2019, luego de los reportajes publicados en The New York Times sobre la proliferación en internet de imágenes de abuso sexual a menores, los miembros del Congreso le dijeron a Apple que tenía que hacer algo más para ayudar a las fuerzas del orden o la obligarían a hacerlo. Dieciocho meses después, Apple anunció que había encontrado una manera de abordar el problema en los iPhones y, al mismo tiempo, proteger la privacidad de sus usuarios.

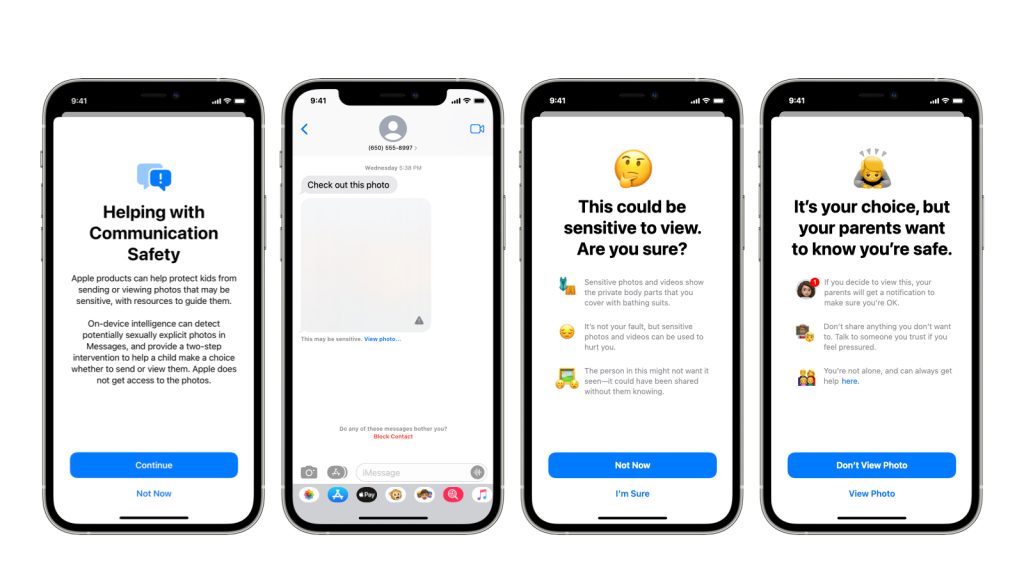

El plan incluía la modificación de su asistente virtual, Siri, para dirigir a las personas que preguntan sobre el abuso sexual infantil a los recursos adecuados. Apple también dijo que pronto les permitiría a los padres activar la tecnología que analiza las imágenes de los mensajes de texto de sus hijos en busca de desnudos. Los niños de 13 años en adelante recibirían una advertencia antes de enviar o ver una fotografía con un desnudo, mientras que los padres podrían solicitar que se les notifique si los niños menores de 13 años lo hacían.

Esos cambios causaron poca controversia en comparación con la tercera herramienta nueva de Apple: un programa que escanea las fotos del iPhone de los usuarios y las compara con una base de datos de imágenes conocidas de abuso sexual infantil.

Para evitar falsos positivos y ocultar las imágenes de abusos, Apple adoptó una estrategia compleja. Su programa reduce cada foto a un conjunto único de números (una especie de huella digital de la imagen llamada hash, o resumen criptográfico) y luego los compara con otros resúmenes criptográficos de imágenes conocidas de abusos a menores proporcionados por grupos como el Centro Nacional para Niños Desaparecidos y Explotados.

Si 30 o más de las fotos de un usuario parecen coincidir con las imágenes de abuso, un trabajador de Apple revisa las coincidencias. Si alguna de las fotografías muestra abusos sexuales a menores, Apple las envía a las autoridades y bloquea la cuenta del usuario. Apple dijo que activaría esta función en Estados Unidos en los próximos meses.

Autoridades policiales, grupos de seguridad infantil, sobrevivientes de abuso y algunos científicos de la computación elogiaron la medida. En declaraciones facilitadas por Apple, el presidente del Centro Nacional para Niños Desaparecidos y Explotados lo calificó como una estrategia revolucionaria, mientras que David Forsyth, catedrático de informática de la Universidad de Illinois en Urbana-Champaign, dijo que la tecnología atraparía a los abusadores de niños y que “los usuarios inofensivos experimentarían una pérdida de privacidad mínima o nula”.

Para muchos expertos en tecnología, Apple ha abierto la caja de Pandora. La herramienta sería la primera tecnología integrada en el sistema operativo de un teléfono que puede analizar los datos privados de una persona y comunicarlos a las autoridades policiales. A los grupos de defensa de la privacidad y a los expertos en seguridad les preocupa que los gobiernos que buscan delincuentes, opositores u otros objetivos puedan encontrar muchas maneras de utilizar un sistema como ese.

Tal y como lo entendemos ahora, no me preocupa tanto que se abuse de la implementación específica de Apple, comentó Alex Stamos, investigador de la Universidad de Stanford que con anterioridad dirigió los trabajos de ciberseguridad de Facebook. El problema es que ahora le han abierto la puerta a una clase de vigilancia que antes no estaba abierta.

Si los gobiernos le hubieran pedido antes a Apple que analizara las fotos de la gente, la empresa podría haber respondido que no podía hacerlo. Ahora que ha construido un sistema que sí puede, Apple debe declarar que no lo hará.

Creo que está claro que Apple ha intentado hacer esto de la manera más responsable posible, pero el problema es que lo estén haciendo en primera instancia, dijo Galperin. Una vez que creas un sistema que puede dirigirse a cualquier base de datos, te pedirán que dirijas el sistema a una base de datos específica.

En respuesta, Apple ha asegurado que no accederá a esas peticiones. Ya nos hemos enfrentado antes a solicitudes para construir e implementar cambios exigidos por el gobierno que afectan la privacidad de los usuarios, y nos hemos negado a esas demandas con firmeza. Seguiremos rechazándolas en el futuro, señaló la empresa en un comunicado.